Google представила Gemini 2.5 – обновленную версию семейства своих ИИ-моделей. В первую очередь усовершенствованный инструмент направлен на выполнение задач в области разработки приложений, создания ИИ-агентов, написания и редактирования кода.

Первой выпущенной моделью семейства стала Gemini 2.5 Pro Experimental – мультимодальная модель со способностью рассуждения, которую компания называет «самой интеллектуальной моделью на сегодняшний день». Она доступна на платформе для разработчиков Google AI Studio.

Также Google заявила, что все ИИ-модели, которые будут создаваться компанией в дальнейшем, будут иметь встроенные функции рассуждения – то есть смогут использовать дополнительную вычислительную мощность для проверки найденной ими же информации перед предоставлением ответа. В частности, такие модели лучше справляются с решением математических задач и написанием кода, а также являются базой для создания автономных ИИ-агентов.

Первую экспериментальную модель с «рассуждением» Google выпустила в декабре прошлого года, но Gemini 2.5 представляет собой уже серьезную попытку компании превзойти серию моделей аналогичного характера от OpenAI.

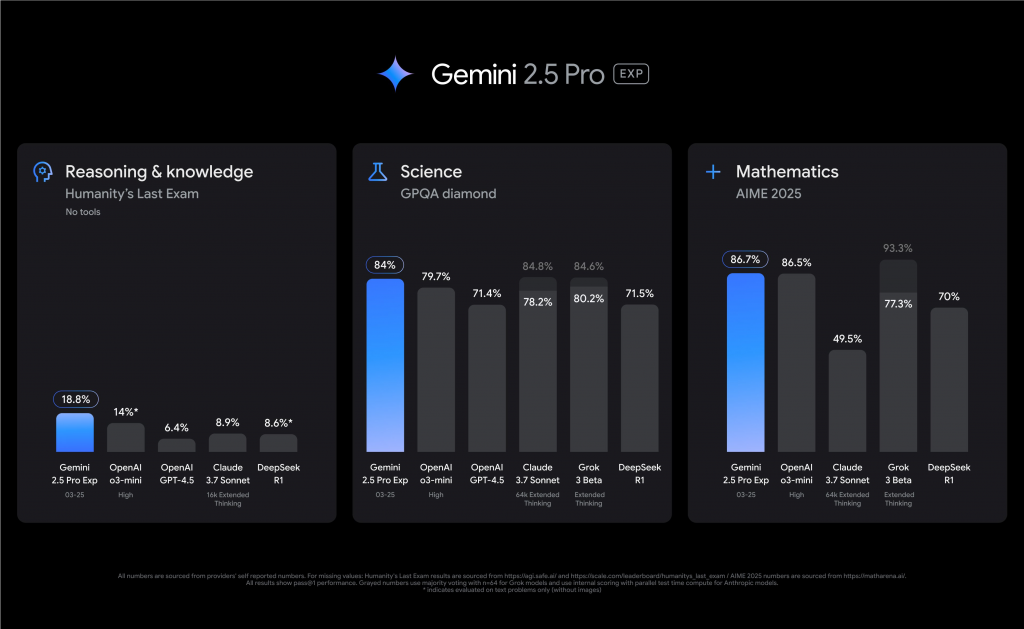

По данным Google, Gemini 2.5 Pro превосходит предыдущие версии модели Gemini и некоторые из ведущих конкурирующих моделей по нескольким бенчмаркам. В частности, в тесте Aider Polyglot по редактированию кода, Gemini 2.5 Pro набрала 68,6%, превзойдя свои аналоги от OpenAI, Anthropic и DeepSeek. При этом в другом тесте SWE-bench Verified, оценивающем возможности инструмента в разработке программного обеспечения, модель набрала 63,8%, превзойдя o3-mini от OpenAI и R1 от DeepSeek, но уступив Claude 3.7 Sonnet от Anthropic, набравшей 70,3%.

В многомодальном тесте Humanity’s Last Exam, состоящем из тысяч вопросов в сфере математики, гуманитарных и естественных наук, Gemini 2.5 Pro набрала 18,8%, превзойдя большинство моделей-конкурентов.

По информации Google, на данный момент Gemini 2.5 Pro запущена с контекстным окном в 1 миллион токенов – это означает, что модель может воспринимать примерно 750 000 слов за один раз. При этом в скором будущем контекстное окно модели планируется увеличить вдвое – до 2 миллионов токенов.

Источник: TechCrunch