В конце апреля компания Microsoft анонсировала выпуск нового набора компактных ИИ-моделей Phi-3. Несмотря на мини-формат, компактные модели (SLM) по своей функциональности превосходят некоторые более крупные аналоги.

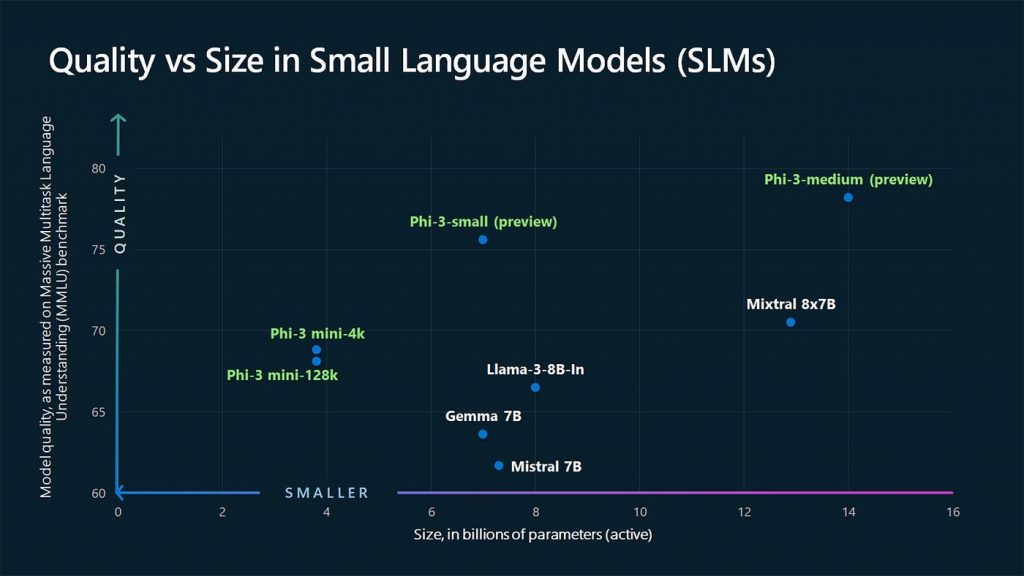

В набор вошли три варианта: Phi-3 mini (3,8 млрд параметров), Phi-3-small (7 млрд параметров) и Phi-3-medium (14 млрд параметров).

- Phi-3-mini представляет собой модель с 3,8 миллиардами параметров, обученную на 3,3 триллионах токенов. Её контекстное окно составляет 4 тысячи токенов и 32 тысячи слов, а в удлиненной версии Phi-3-mini-128K окно расширено до 128 тысячи токенов. По оценке бенчмарка MMLU производительность этой модели составляет 69%, по MT-bench – 8,38. Версия Phi-3-mini-128K, по информации из блога компании, в плане обработки и генерации текстов на естественном языке стоит на одном уровне с Mixtral 8x7B от Mistral AI и GPT 3.5 от OpenAI – при том, что её мини-формат позволяет развернуть инструмент даже на смартфоне.

- Phi-3-small имеет 7 миллиардов параметров и обучена на 4,8 триллионах токенов. Контекстное окно здесь составляет 8 тысяч токенов, вокабуляр – 100 тысяч слов.

- У Phi-3-medium – 14 миллиардов параметров и обучение на 4,8 триллионах токенов.

На иллюстрациях ниже представлено сравнение производительности новых моделей по сравнению с некоторыми конкурентными моделями:

На данный момент компания выпустила только Phi-3-mini, а две остальные модели ещё проходят обучение и будут выпущены в скором времени.

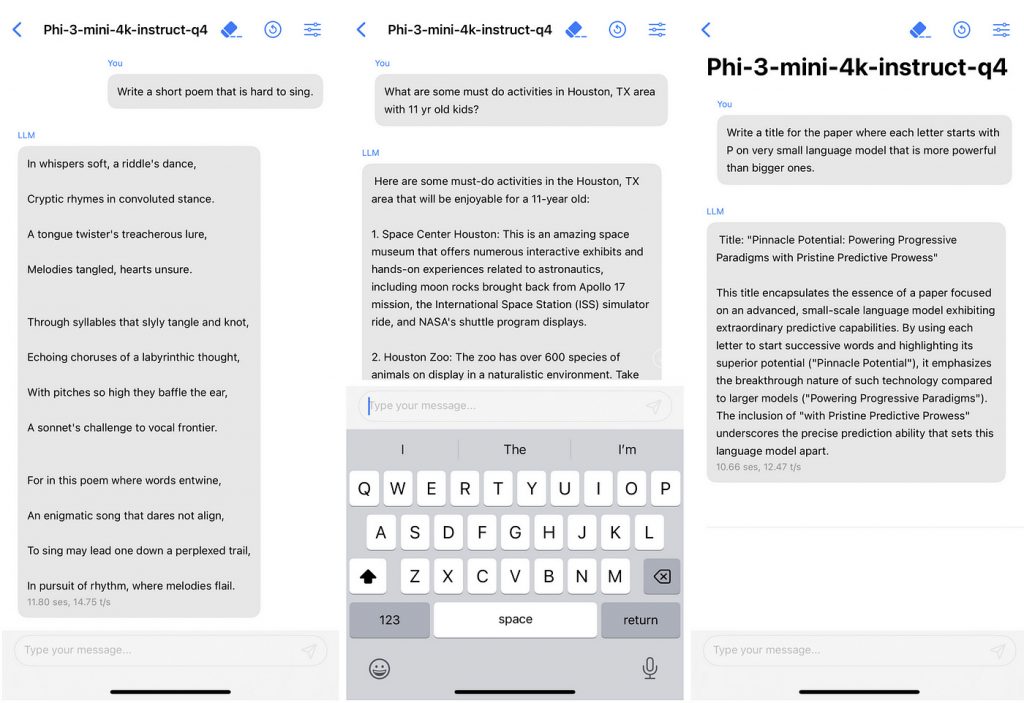

Отличительной чертой мини-модели является не только её производительность, но и возможность развертывания на устройствах разной мощности без ущерба для качества работы. Это происходит за счёт того, что модели меньшего размера могут быстрее обрабатывать данные, требуя при этом меньше эксплуатационных расходов и вычислительных ресурсов.

Сейчас Phi-3-mini доступна в обеих вариантах (4K и 128K) на облачной платформе Microsoft Azure, а также на платформах с открытым исходным кодом Hugging Face и Ollama.

В статье, посвященной анонсу нового набора, разработчики отдельно подчеркнули ту пользу, которую могут принести небольшие языковые модели при правильном обучении. В частности, Phi-3-mini может открыть путь для создания более высокопроизводительных компактных моделей, которые смогут работать на мобильных устройствах. Конечно, на данном этапе развития их производительность не дотягивает до таких крупных конкурентов, как GPT-4, но уже в обозримом будущем разрыв между крупными и малыми моделями может значительно сократиться.

Источники: techstartups.com; generativeaipub.com